Markov-processer blev udviklet af videnskabsmænd i 1907. Førende matematikere på den tid udviklede denne teori, nogle af dem forbedrer den stadig. Dette system strækker sig også til andre videnskabelige områder. Praktiske Markov-kæder bruges i forskellige områder, hvor en person skal ankomme i en forventningstilstand. Men for at forstå systemet klart, skal du have kendskab til vilkårene og bestemmelserne. Tilfældighed anses for at være den vigtigste faktor, der bestemmer Markov-processen. Sandt nok ligner det ikke begrebet usikkerhed. Den har visse betingelser og variabler.

Funktioner ved tilfældighedsfaktoren

Denne tilstand er underlagt statisk stabilitet, mere præcist dens regelmæssigheder, som ikke tages i betragtning i tilfælde af usikkerhed. Til gengæld tillader dette kriterium brugen af matematiske metoder i teorien om Markov-processer, som bemærket af en videnskabsmand, der studerede dynamikken i sandsynligheder. Det arbejde, han skabte, beskæftigede sig direkte med disse variabler. Til gengæld er den undersøgte og udviklede tilfældige proces, som har begreberne stat ogovergang, samt bruges i stokastiske og matematiske problemer, samtidig med at disse modeller kan fungere. Det giver blandt andet mulighed for at forbedre andre vigtige anvendte teoretiske og praktiske videnskaber:

- diffusionsteori;

- køteori;

- teori om pålidelighed og andre ting;

- kemi;

- fysik;

- mekanik.

Væsentlige træk ved en ikke-planlagt faktor

Denne Markov-proces er drevet af en tilfældig funktion, det vil sige, at enhver værdi af argumentet betragtes som en given værdi eller en, der antager en forud-forberedt form. Eksempler er:

- oscillationer i kredsløbet;

- bevægelseshastighed;

- overfladeruhed i et givet område.

Det er også almindeligt antaget, at tid er en kendsgerning af en tilfældig funktion, det vil sige, at indeksering forekommer. En klassifikation har form af en tilstand og et argument. Denne proces kan være med diskrete såvel som kontinuerlige tilstande eller tid. Desuden er sagerne forskellige: alt sker enten i en eller anden form eller samtidigt.

Detaljeret analyse af begrebet tilfældighed

Det var ret svært at bygge en matematisk model med de nødvendige præstationsindikatorer i en klart analytisk form. I fremtiden blev det muligt at realisere denne opgave, fordi der opstod en tilfældig Markov-proces. Analyserer dette koncept i detaljer, er det nødvendigt at udlede en bestemt sætning. En Markov-proces er et fysisk system, der har ændret sitposition og tilstand, der ikke er forprogrammeret. Det viser sig således, at der foregår en tilfældig proces i den. For eksempel: en rumbane og et skib, der sendes ind i den. Resultatet blev kun opnået på grund af nogle unøjagtigheder og justeringer, uden hvilke den angivne tilstand ikke er implementeret. De fleste af de igangværende processer er iboende i tilfældighed, usikkerhed.

Med hensyn til fordele vil næsten enhver mulighed, der kan overvejes, være underlagt denne faktor. Et fly, en teknisk enhed, en spisestue, et ur - alt dette er underlagt tilfældige ændringer. Desuden er denne funktion iboende i enhver igangværende proces i den virkelige verden. Men så længe dette ikke gælder for individuelt indstillede parametre, opfattes de forstyrrelser, der opstår, som deterministiske.

Konceptet med en Markov stokastisk proces

Design af enhver teknisk eller mekanisk enhed tvinger skaberen til at tage højde for forskellige faktorer, især usikkerheder. Beregningen af tilfældige udsving og forstyrrelser opstår på tidspunktet for personlig interesse, for eksempel ved implementering af en autopilot. Nogle af de processer, der studeres i videnskaber som fysik og mekanik er.

Men at være opmærksom på dem og udføre streng forskning bør begynde i det øjeblik, hvor det er direkte nødvendigt. En tilfældig Markov-proces har følgende definition: sandsynligheden for den fremtidige form afhænger af den tilstand, den er i på et givet tidspunkt, og har intet at gøre med, hvordan systemet så ud. Så givetkonceptet indikerer, at udfaldet kan forudsiges, idet man kun overvejer sandsynligheden og glemmer baggrunden.

Detaljeret forklaring af konceptet

I øjeblikket er systemet i en bestemt tilstand, det bevæger sig og ændrer sig, det er dybest set umuligt at forudsige, hvad der vil ske næste gang. Men givet sandsynligheden kan vi sige, at processen vil blive afsluttet i en bestemt form eller bevare den forrige. Det vil sige, at fremtiden opstår fra nutiden og glemmer fortiden. Når et system eller en proces går ind i en ny tilstand, udelades historikken norm alt. Sandsynlighed spiller en vigtig rolle i Markov-processer.

Geigertælleren viser f.eks. antallet af partikler, som afhænger af en bestemt indikator og ikke af det nøjagtige øjeblik, den kom. Her er hovedkriteriet ovenstående. I praktisk anvendelse kan ikke kun Markov-processer overvejes, men også lignende, for eksempel: fly deltager i systemets kamp, som hver især er angivet med en farve. I dette tilfælde er hovedkriteriet igen sandsynligheden. På hvilket tidspunkt overvægten i antal vil forekomme, og for hvilken farve, er ukendt. Det vil sige, at denne faktor afhænger af systemets tilstand og ikke af rækkefølgen af flydødsfald.

Strukturanalyse af processer

En Markov-proces er enhver tilstand i et system uden en sandsynlig konsekvens og uden hensyntagen til historien. Altså hvis man inkluderer fremtiden i nutiden og udelader fortiden. Overmætning af denne tid med forhistorie vil føre til multidimensionalitet ogvil vise komplekse konstruktioner af kredsløb. Derfor er det bedre at studere disse systemer med simple kredsløb med minimale numeriske parametre. Som et resultat heraf betragtes disse variable som bestemmende og betinget af nogle faktorer.

Et eksempel på Markov-processer: en fungerende teknisk enhed, der er i god stand i øjeblikket. I denne situation er det af interesse sandsynligheden for, at enheden vil fungere i en længere periode. Men hvis vi opfatter udstyret som fejlrettet, vil denne mulighed ikke længere tilhøre den undersøgte proces på grund af det faktum, at der ikke er nogen information om, hvor længe enheden fungerede før, og om reparationer blev foretaget. Men hvis disse to tidsvariable suppleres og inkluderes i systemet, kan dets tilstand tilskrives Markov.

Beskrivelse af diskret tilstand og kontinuitet i tiden

Markov-procesmodeller anvendes i det øjeblik, hvor det er nødvendigt at negligere forhistorien. Til forskning i praksis støder man oftest på diskrete, kontinuerlige tilstande. Eksempler på en sådan situation er: Udstyrets struktur omfatter knudepunkter, der kan svigte i arbejdstiden, og det sker som en uplanlagt, tilfældig handling. Som et resultat heraf gennemgår systemets tilstand reparation af det ene eller det andet element, i dette øjeblik vil en af dem være sund, eller begge vil blive fejlrettet, eller omvendt, de er fuldt justeret.

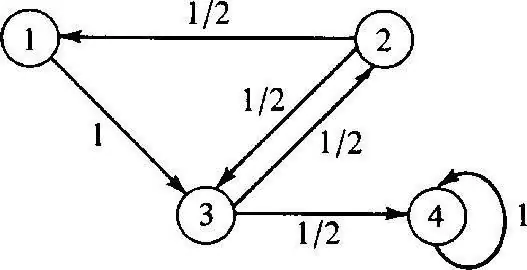

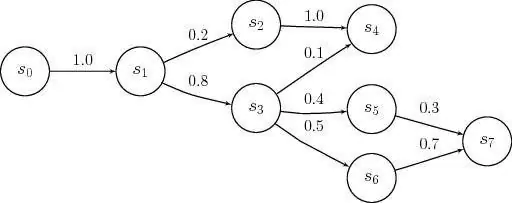

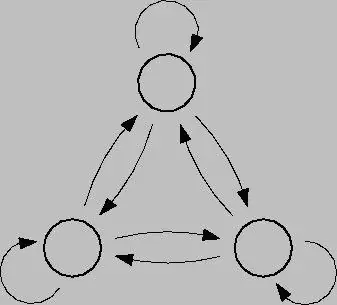

Den diskrete Markov-proces er baseret på sandsynlighedsteori og er det ogsåsystemets overgang fra en tilstand til en anden. Desuden opstår denne faktor med det samme, selvom der opstår utilsigtede nedbrud og reparationsarbejde. For at analysere en sådan proces er det bedre at bruge tilstandsgrafer, det vil sige geometriske diagrammer. Systemtilstande i dette tilfælde er angivet med forskellige former: trekanter, rektangler, prikker, pile.

Modellering af denne proces

Diskret-state Markov processer er mulige modifikationer af systemer som følge af en øjeblikkelig overgang, og som kan nummereres. For eksempel kan du bygge en tilstandsgraf ud fra pile til knudepunkter, hvor hver vil angive stien for forskelligt rettede fejlfaktorer, driftstilstand osv. I fremtiden kan der opstå spørgsmål: såsom det faktum, at ikke alle geometriske elementer peger i den rigtige retning, for i processen kan hver knude forringes. Når du arbejder, er det vigtigt at overveje lukninger.

Kontinuerlig-tids Markov-proces opstår, når dataene ikke er præfikseret, det sker tilfældigt. Overgange var ikke tidligere planlagt og forekommer i hop på noget tidspunkt. I dette tilfælde spilles hovedrollen igen af sandsynlighed. Men hvis den nuværende situation er en af ovenstående, så kræves der en matematisk model for at beskrive den, men det er vigtigt at forstå mulighedsteorien.

Probabilistiske teorier

Disse teorier betragter som sandsynlighed, idet de har karakteristiske træk somtilfældig rækkefølge, bevægelse og faktorer, matematiske problemer, ikke deterministiske, som er sikre nu og da. En kontrolleret Markov-proces har og er baseret på en mulighedsfaktor. Desuden er dette system i stand til at skifte til enhver tilstand øjeblikkeligt under forskellige forhold og tidsintervaller.

For at omsætte denne teori i praksis er det nødvendigt at have en vigtig viden om sandsynlighed og dens anvendelse. I de fleste tilfælde er man i en forventningstilstand, hvilket i generel forstand er den pågældende teori.

Eksempler på sandsynlighedsteori

Eksempler på Markov-processer i denne situation kan være:

- cafe;

- billetkontorer;

- værksteder;

- stationer til forskellige formål osv.

Som regel beskæftiger folk sig med dette system hver dag, i dag kaldes det at stå i kø. På anlæg, hvor en sådan service er til stede, er det muligt at kræve forskellige ønsker, som bliver tilfredsstillet i processen.

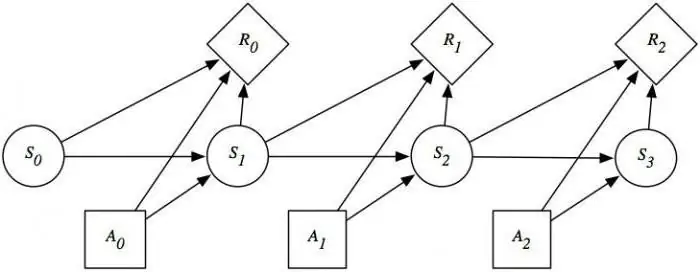

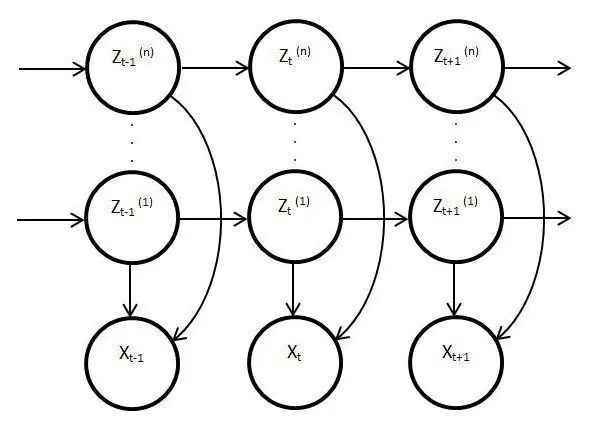

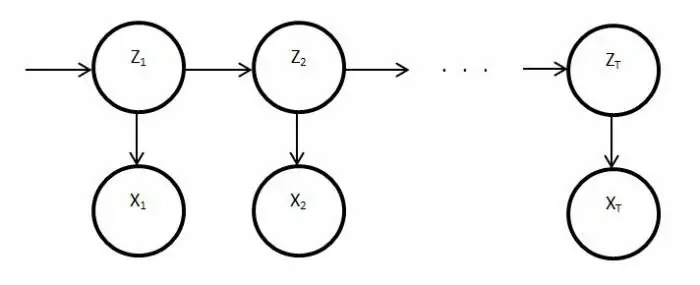

Skjulte procesmodeller

Sådanne modeller er statiske og kopierer arbejdet fra den originale proces. I dette tilfælde er hovedfunktionen funktionen til at overvåge ukendte parametre, der skal udredes. Som et resultat kan disse elementer bruges i analyse, praksis eller til at genkende forskellige objekter. Almindelige Markov-processer er baseret på synlige overgange og på sandsynlighed, kun ukendte observeres i den latente modelvariabler påvirket af staten.

Væsentlig offentliggørelse af skjulte Markov-modeller

Den har også en sandsynlighedsfordeling blandt andre værdier, som et resultat, vil forskeren se en sekvens af tegn og tilstande. Hver handling har en sandsynlighedsfordeling blandt andre værdier, så den latente model giver information om de genererede successive tilstande. De første noter og henvisninger til dem dukkede op i slutningen af tresserne af forrige århundrede.

Så blev de brugt til talegenkendelse og som analyser af biologiske data. Derudover har latente modeller spredt sig i skrift, bevægelser, datalogi. Disse elementer imiterer også arbejdet i hovedprocessen og forbliver statiske, men på trods af dette er der meget mere karakteristiske træk. Dette forhold vedrører især direkte observation og sekvensgenerering.

Stationær Markov-proces

Denne betingelse eksisterer for en homogen overgangsfunktion såvel som for en stationær fordeling, som betragtes som hoved- og per definition en tilfældig handling. Faserummet for denne proces er et begrænset sæt, men i denne tilstand eksisterer den indledende differentiering altid. Overgangssandsynligheder i denne proces tages i betragtning under tidsforhold eller yderligere elementer.

En detaljeret undersøgelse af Markovs modeller og processer afslører spørgsmålet om at tilfredsstille balancen på forskellige områder af livetog samfundets aktiviteter. I betragtning af, at denne industri påvirker videnskab og massetjenester, kan situationen korrigeres ved at analysere og forudsige resultatet af eventuelle begivenheder eller handlinger af det samme defekte ure eller udstyr. For fuldt ud at bruge funktionerne i Markov-processen er det værd at forstå dem i detaljer. Denne enhed har trods alt fundet bred anvendelse ikke kun i videnskab, men også i spil. Dette system i sin rene form tages norm alt ikke i betragtning, og hvis det bruges, så kun på basis af ovenstående modeller og skemaer.